Über STACKIT

STACKIT ist die Cloud-Plattform der Schwarz Gruppe (Lidl, Kaufland) und bietet als deutscher Cloud-Provider eine vollständig souveräne Alternative zu US-amerikanischen Hyperscalern. Mit Rechenzentren ausschließlich in Deutschland garantiert STACKIT maximale Datensouveränität.

Die Herausforderung

Die Schwarz Gruppe setzt auf einen souveränen Google Workspace und benötigte einen internen KI-Assistenten für Mitarbeiterschulungen - mit einer klaren Anforderung: Keine Daten dürfen Deutschland verlassen.

Klassische KI-Lösungen wie ChatGPT oder Claude waren keine Option, da sie auf US-Servern laufen und sensible Unternehmensdaten verarbeiten würden.

Die Lösung: STACKI - Der souveräne Chatbot

innFactory entwickelte STACKI, einen RAG-basierten Chatbot, der vollständig auf STACKIT-Infrastruktur läuft und ausschließlich deutsche Rechenzentren nutzt.

Technische Architektur

LLM-Inferenz:

- LLama 3 als Open Source Large Language Model

- STACKIT Model Serving für GPU-beschleunigte Inferenz

- Keine Abhängigkeit von externen KI-Providern

Retrieval Augmented Generation (RAG):

- PGVector in PostgreSQL für Vektor-Embeddings

- Indizierung interner Schulungsmaterialien

- Kontextbezogene Antworten basierend auf Unternehmenswissen

Cloud-Native auf STACKIT:

- STACKIT Kubernetes Engine (SKE) für Container-Orchestrierung

- STACKIT Git für Versionsverwaltung und CI/CD

- Vollständig deutsche Infrastruktur

Was ist RAG?

Retrieval Augmented Generation kombiniert die Stärken von Large Language Models mit unternehmensspezifischem Wissen:

- Retrieval: Relevante Dokumente werden aus der Wissensbasis abgerufen

- Augmentation: Diese Dokumente werden als Kontext an das LLM übergeben

- Generation: Das LLM generiert eine Antwort basierend auf dem bereitgestellten Kontext

Das Ergebnis: Präzise Antworten mit Bezug auf interne Dokumente - ohne dass das LLM auf diese Daten trainiert werden muss.

Unsere Leistungen

- Architektur-Design für souveräne KI-Anwendungen

- RAG-Pipeline Entwicklung und Optimierung

- LLM-Integration mit STACKIT Model Serving

- Vektor-Datenbank Setup mit PGVector

- Kubernetes Deployment auf STACKIT SKE

- DevOps-Pipeline mit STACKIT Git

Das Ergebnis

Mit STACKI hat die Schwarz Gruppe einen KI-Assistenten, der:

- 100% souverän in deutschen Rechenzentren läuft

- Interne Dokumente intelligent durchsucht und zusammenfasst

- Mitarbeiterschulungen zum souveränen Google Workspace unterstützt

- Keine Daten an externe Anbieter überträgt

- DSGVO-konform und AI-Act-ready ist

Warum STACKIT?

| Aspekt | US-Hyperscaler | STACKIT |

|---|---|---|

| Datenspeicherung | Global verteilt | Nur Deutschland |

| Rechtsrahmen | US CLOUD Act | Deutsches Recht |

| LLM-Anbieter | OpenAI, Anthropic | Open Source (LLama) |

| Datenzugriff | Theoretisch möglich | Ausgeschlossen |

| Souveränität | Eingeschränkt | Vollständig |

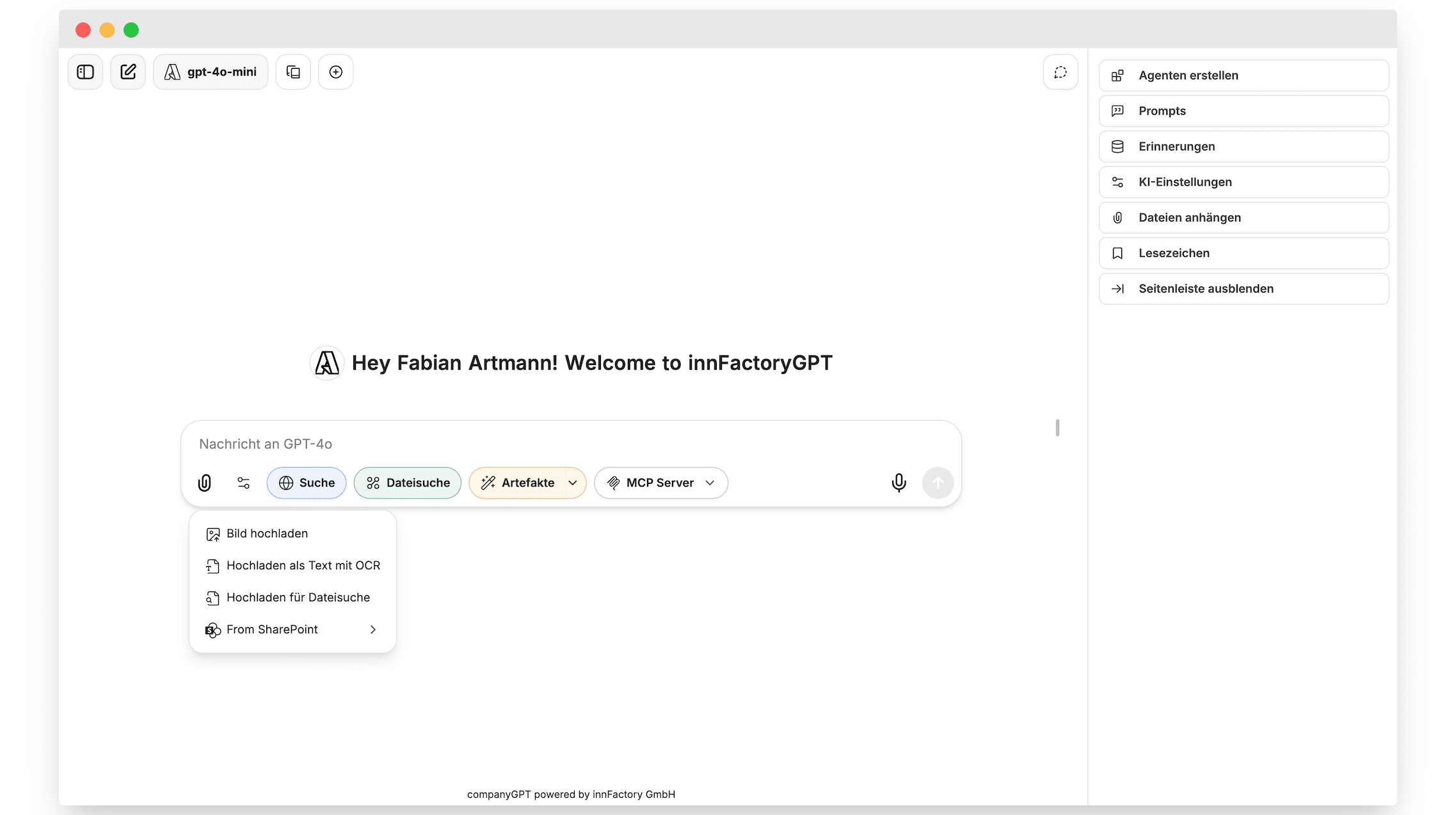

CompanyGPT auf STACKIT

Basierend auf dieser Referenz ist unser CompanyGPT Produkt nun auch mit STACKIT Model Serving kompatibel. Unternehmen können damit einen vollständig souveränen KI-Assistenten betreiben - Made in Germany.

Verknüpfte Leistungen: STACKIT Cloud | KI & Machine Learning | Digitale Souveränität

Entwickelt in Partnerschaft mit STACKIT, dem souveränen Cloud-Provider der Schwarz Gruppe.